Bị mất hàng nghìn USD vì AI giả giọng người thân & Kỹ thuật tạo ra giọng nói Thông Minh Giả Tạo (St). Fr: MInh Đỗ Texas

Minh Nguyen Quang

Bị mất hàng nghìn USD vì AI giả giọng người thân & Kỹ thuật tạo ra giọng nói Thông Minh Giả Tạo

Cơn ác mộng của gia đình Perkin, 39 tuổi, bắt đầu khi một người tự nhận là luật sư gọi cho cha mẹ anh, nói anh đã gây ra vụ tai nạn xe hơi, khiến một nhà ngoại giao Mỹ tử vong. Người này cho biết Perkin đang ở trong tù và cần tiền cho các chi phí pháp lý.

Để tăng độ tin cậy, người này chuyển máy cho Perkin, thực chất là kết nối với thiết bị AI giả giọng. Trong đó, "Perkin" nói rất cần tiền, chỉ còn biết tin tưởng vào cha mẹ.

"Giọng nói đủ gần gũi khiến cha mẹ tôi tin đó là tôi", Perkin kể với Washington Post.

Vài giờ sau, "luật sư" hối thúc cha mẹ anh chuyển tiền, nên họ đã ra ngân hàng rút và gửi đi 15.449 USD thông qua một hệ thống chuyển đổi sang Bitcoin. Cha mẹ anh nói họ có cảm giác cuộc gọi "có gì đó bất thường", nhưng vẫn làm theo vì nghĩ đã nói chuyện với con trai. Tối hôm đó, khi Perkin gọi điện, tất cả mới vỡ lẽ.

Perkin nghi ngờ các video anh đăng trên YouTube là nguồn âm thanh cho kẻ lừa đảo huấn luyện AI. "Tiền đã mất. Không có bảo hiểm. Lấy lại là không thể", anh nói.

Tương tự, một buổi sáng, bà Ruth Card, 73 tuổi ở Regina (Canada), nhận được cuộc gọi từ người lạ. Người này nói cháu bà, anh Brandon, bị tạm giam, không có smartphone để liên lạc và cần một số tiền để được tại ngoại.

"Trong đầu tôi lúc đó chỉ lóe lên suy nghĩ rằng tôi phải giúp thằng bé ngay lập tức", bà nói với Washington Post. Bà cùng chồng đến ngân hàng và rút 2.207 USD - mức tối đa bà có thể rút hàng ngày. Cả hai định qua ngân hàng thứ hai để lấy số tiền tương tự.

May mắn cho họ là vị giám đốc ngân hàng đã gọi cả hai vào văn phòng và cho biết: một khách hàng khác cũng nhận được cuộc gọi giống hệt, cũng bị giả giọng người thân với mức "chính xác đến kỳ lạ". Cả hai gọi điện cho cháu trai và đúng là anh không bị bắt.

"Chúng tôi bị cuốn theo câu chuyện mà không tìm hiểu kỹ. Khi đó, tôi tin chắc đang nói chuyện với Brandon mà không nghi ngờ", bà Card cho hay.

Các vụ lừa đảo công nghệ tăng mạnh thời gian qua, nhưng câu chuyện của bà Card hay Perkin cho thấy xu hướng mới đáng lo ngại: kẻ gian đang lợi dụng AI bắt chước giọng nói cho mục đích lừa tiền. Công nghệ này ngày càng rẻ, dễ tiếp cận khiến số nạn nhân ngày càng tăng, chủ yếu nhắm đến người lớn tuổi.

Theo dữ liệu từ Ủy ban Thương mại Liên bang Mỹ (FTC), trong năm 2022, mạo danh là hình thức lừa đảo phổ biến thứ hai ở Mỹ với hơn 36.000 báo cáo. Kẻ gian thường giả mạo bạn bè hoặc gia đình để khiến nạn nhân mắc lừa. Riêng lừa đảo qua điện thoại chiếm hơn 5.100 trường hợp, gây thiệt hại hơn 11 triệu USD.

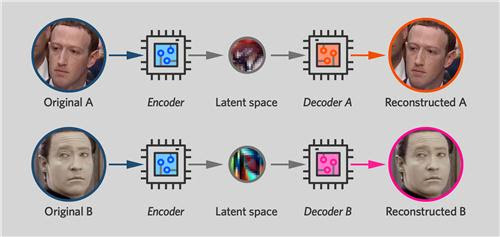

Sự tiến bộ của AI thời gian qua nhiều lĩnh vực phát triển, nhưng cũng là công cụ để kẻ xấu khai thác. Chỉ bằng một mẫu âm thanh trong một vài câu nói thu thập được, kẻ gian có thể dùng trí tuệ nhân tạo chuyển thành bản sao giọng nói của một người. Công cụ sau đó "nói" bất cứ thứ gì theo yêu cầu và trở thành phương tiện lừa đảo.

Giới chuyên gia đánh giá, công cụ AI giả giọng nói đang tràn lan, nhưng các cơ quan quản lý vẫn loay hoay kiểm soát.

Trong khi đó, hầu hết nạn nhân đều khó xác định thủ phạm vì kẻ lừa đảo hoạt động trên khắp thế giới. Các công ty tạo ra AI cũng chưa phải chịu trách nhiệm về việc chúng bị kẻ khác lạm dụng.

"Thật đáng sợ. Mọi thứ tạo thành cơn bão, đưa nạn nhân lạc vào sự hỗn loạn", giáo sư Hany Farid tại Đại học California nhận xét. "Kẻ gian sẽ buộc nạn nhân phải phản ứng nhanh, khiến họ không đủ bình tĩnh để xử lý vấn đề, đặc biệt là khi nghe tin người thân gặp nguy hiểm".

Cũng theo ông, phần mềm AI ngày nay đủ thông minh để phân tích giọng nói của một người. "Chỉ cần một bản ghi âm từ Facebook, TikTok, giọng nói của bạn sẽ được sao chép chỉ trong 30 giây", giáo sư Farid nói.

ElevenLabs, công ty đứng sau VoiceLab - công cụ AI tái tạo giọng nói, cảnh báo ngày càng nhiều phần mềm giả giọng có mặt trên thị trường, dẫn đến tình trạng lạm dụng.

Trong khi đó, Will Maxson, hiện làm việc tại Ủy ban Thương mại liên bang Mỹ FTC, cho biết việc theo dõi kẻ lừa đảo giọng nói "đặc biệt khó khăn" vì chúng có thể sử dụng điện thoại và ở bất kỳ đâu.

Theo ông, nếu nhận cuộc gọi từ người lạ hoặc từ người thân nhờ hỗ trợ, người dùng cần kiểm tra bằng cách gọi lại cho chính người đang gặp sự cố, cũng như gọi cho các thành viên khác trong gia đình để xác minh thông tin.

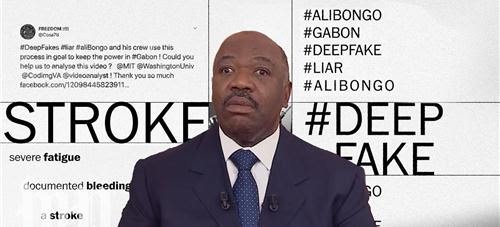

Lừa đảo bằng deepfake tăng hơn 1,000%

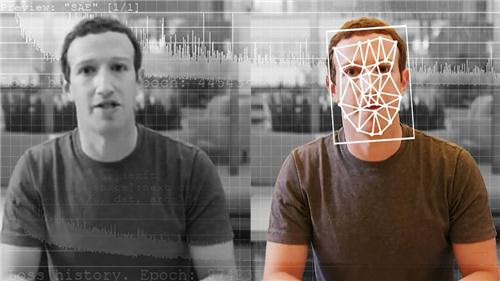

Khi ranh giới giữa thực tại và hư cấu ngày càng khó phân biệt, tội phạm trực tuyến chỉ cần hai tiếng đồng hồ để khiến máy điện toán tạo ra một sản phẩm “deepfake” như thật, vốn có thể hủy hoại cuộc sống của một người nào đó.

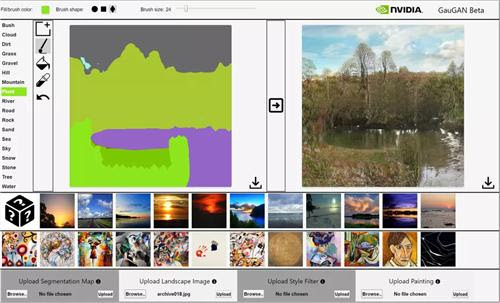

Sự gia tăng về mức độ phổ biến của các hình ảnh, âm thanh, và video siêu thực được phát triển bằng trí tuệ nhân tạo (AI) thường được gọi là deepfake đã khiến người dùng Internet giật mình.

https://www.youtube.com/watch?v=cQ54GDm1eL0&ab_channel=BuzzFeedVideo

Công nghệ này cũng mang lại cho những kẻ bại hoại trên mạng một lợi thế trong giới tội phạm.

Từ năm 2022 đến quý đầu tiên của năm nay (2023), chỉ riêng ở Hoa Kỳ, việc sử dụng deepfake để lừa đảo đã tăng đến 1,200%.

Dù vậy, vấn đề này không chỉ xảy ra ở Mỹ.

Cùng một phân tích cho thấy deepfake được sử dụng cho mục đích lừa đảo đã bùng nổ ở Canada, Đức, và Vương quốc Anh. Trong nghiên cứu, Hoa Kỳ chiếm 4.3% các vụ lừa đảo deepfake toàn cầu.

Trong khi đó, các chuyên gia AI và các nhà điều tra tội phạm mạng nói rằng chúng ta mới chỉ thấy phần nổi của tảng băng. Những hiện tượng phức tạp của lừa đảo bằng deepfake vẫn tiếp tục.

Ông Michael Roberts nói: “Tôi tin rằng động cơ số 1 khiến bọn tội phạm trực tuyến hoành hành trên mạng là do cơ quan chấp pháp và khả năng theo sát của họ.”

https://www.youtube.com/watch?v=ZaxWPog4h28&t=9s&ab_channel=RapMusic

Ông Roberts là một nhà điều tra chuyên nghiệp và là nhà sáng lập công ty tiên phong Rexxfiled chuyên giúp đỡ nạn nhân của các cuộc tấn công trên web.

Ông cũng thành lập PICDO, một tổ chức chống tội phạm trực tuyến và điều hành chương trình đào tạo chống xâm nhập mạng cho các quân chủng của quân đội Hoa Kỳ, Úc cũng như NATO.

Ông Roberts cho biết, hệ thống luật pháp ở thế giới Tây phương đang bị các vụ lừa đảo trực tuyến “lấn át trong vô vọng,” trong đó có nhiều vụ tấn công bằng deepfake. Hơn nữa, phương pháp chọn lựa được sử dụng để quyết định xem vụ nào được điều tra mà không cần thuê các công ty tư nhân.

Ông cho biết: “Và cho dù như thế, vụ việc vẫn không được giải quyết.”

Theo báo cáo của HSRC, vào năm 2020, thị trường các công cụ phát hiện deepfake được định giá 3.86 tỷ USD và dự báo sẽ tăng trưởng 42% mỗi năm cho đến năm 2026.

Trò đánh lận con đen

Hãy hình dung quý vị nhận được một cú điện thoại từ một người thân yêu, vừa khóc vừa nói rằng họ bị bắt cóc. Đương nhiên, những kẻ bắt cóc muốn có tiền, còn giọng nói của thân nhân quý vị tiếp tục hướng dẫn cách thức giao tiền chuộc.

Quý vị có thể tin rằng ở đầu dây bên kia là giọng nói của người mà quý vị thương yêu, nhưng cũng có thể không phải.

Trong năm nay, các vụ lừa đảo bằng âm thanh deepfake hay “nhân bản giọng nói” đã lan ra rất nhanh trên khắp Hoa Kỳ, khiến những người có lòng trắc ẩn và không có sự đề phòng ở nhiều tiểu bang bị bất ngờ.

Tuy nhiên sự việc không dừng lại ở đó. Các cuộc tấn công deepfake có thể xảy ra dưới nhiều hình thức khác nhau. Những trò lừa đảo khôn lanh này cũng có thể xuất hiện dưới dạng trò chuyện video với người mà quý vị biết.

Các vụ lừa đảo cũng có thể xuất hiện dưới dạng bài đăng trên mạng xã hội của một đồng nghiệp lâu năm để thảo luận cách để khoản đầu tư tiền mã hóa giúp cho họ mua căn nhà mới đẹp đẽ mà họ đang hào hứng chỉ cho quý vị thấy trong một bức ảnh.

Ông Roberts nói: “Chúng ta đã bắt gặp rất nhiều vụ lừa đảo tiền mã hóa.”

Deepfake cũng được sử dụng để tống tiền. Phương thức thường là tạo ra một video hoặc ảnh chất lượng tàm tạm của nạn nhân trong một tình huống dâm ô hoặc gây mất thể diện.

Từng vụ việc trong số những ví dụ nói trên đã thật sự diễn ra.

Tuy nhiên để tạo ra những thứ giả mạo như thật này, bọn tội phạm cần có quyền truy cập vào các tài liệu như ảnh, âm thanh, và video. Thật không may, lấy được những tư liệu này là điều không khó.

Ông Roberts nói: “Nếu ai đó truy cập vào các ảnh riêng tư trong iCloud của quý vị vốn cung cấp tất cả các mẫu ảnh, thì toàn bộ công nghệ này… sẽ tạo ra những bức ảnh giả siêu thực.”

Hồ sơ truyền thông xã hội là một nguồn tư liệu quý báu cho những tên tội phạm đang tìm cách tạo ra những sản phẩm này.

Con đường để nạn nhân thu hồi tài sản bị mất và danh tiếng có thể rất nghiệt ngã. Ông Roberts lưu ý rằng vụ kiện tụng chống lại tội phạm trực tuyến là một cuộc chiến khó khăn. “Đó là quá trình kéo dài, gian khổ, dai dẳng, và bào mòn người ta về cảm xúc lẫn tài chính.”

Những người khác trong ngành AI nói rằng vấn đề không chỉ nằm ở chất lượng của các sản phẩm giả mạo mà còn ở số lượng.

Ông Alan Ikoev nói: “Sớm hay muộn, người ta sẽ có thể tạo ra bất kỳ tổ hợp pixel của bất kỳ loại nội dung nào. Và việc gạn lọc là tùy thuộc vào quý vị.”

Ông Ikoev là giám đốc điều hành của Fame Flow, công ty tạo ra các quảng cáo dành cho người nổi tiếng và người có ảnh hưởng được cấp phép.

Là một người tiên phong về nội dung được ủy quyền do AI tạo ra liên quan đến những người nổi tiếng, ông đã quá quen thuộc với những hoạt động của các đồng nghiệp phản diện.

Nhưng để chống lại những trò gian lận ngày càng tinh vi này, mọi người cần phải ngờ vực mọi thứ họ nhìn thấy trên mạng. Ông Ikoev nói: “Nếu họ không đặt nghi vấn, thì họ sẽ dễ dàng tin theo.”

Phân biệt thật giả trên mạng đã trở nên khó khăn. Theo một cuộc khảo sát của Ipsos với hơn 25,000 người tham gia ở 25 quốc gia, 86% người dùng Internet thừa nhận họ đã bị các tin tức giả đánh lừa.

Cuộc khảo sát này được kết hợp với một nghiên cứu an ninh mạng gần đây, cho thấy hiện nay các bot tạo ra gần một nửa lưu lượng truy cập Internet.

Nhưng toàn bộ tin xấu không dừng lại ở đó. Ông Roberts cho rằng bọn tội phạm chưa bắt kịp tốc độ phát triển của công nghệ vốn hiện đang vượt xa “những nhân tố xấu.”

Tuy nhiên, cần phải cảnh giác và có sẵn một kế hoạch để đẩy lùi hoặc chống lại các cuộc tấn công bằng deepfake.

Các hành động và biện pháp đối phó

Sự tiến bộ nhanh chóng của công nghệ lừa đảo dường như gợi lên hoài niệm về cái thời mà các vụ lừa đảo trên Internet chỉ là một thư điện tử từ một hoàng tử tự xưng ở một vùng đất xa xôi nào đó cần giúp chuyển tiền.

AI đã cung cấp cho tội phạm mạng những công cụ tốt hơn, nhưng công nghệ này cũng có thể được sử dụng để chống tội phạm.

Ông Nikita Sherbina, giám đốc điều hành của AIScreen, nói với The Epoch Times, “Việc phát triển các công cụ phát hiện deepfake tân tiến áp dụng thuật toán do AI điều khiển là vô cùng quan trọng để chống lại mối đe dọa này. Nỗ lực hợp tác giữa các nhà phát triển AI, nhà nghiên cứu, và công ty công nghệ là điều cần thiết để tạo ra các biện pháp bảo mật mạnh mẽ và nâng cao nhận thức.”

Ông Sherbina cho biết các doanh nghiệp có thể tự bảo vệ mình bằng cách tăng cường công nghệ. Thực chất là biện pháp lấy đòn phản đòn về kỹ thuật số.

Ông nói: “Hãy khai triển các hệ thống xác thực tân tiến dựa trên AI, bao gồm nhận dạng giọng nói và khuôn mặt cùng với xác thực đa yếu tố. Việc liên tục theo dõi và phân tích các mẫu giao tiếp bằng thuật toán AI cũng có thể giúp phát hiện và ngăn chặn các hoạt động lừa đảo.”

Nhưng với mỗi cá nhân, việc phá vỡ hoặc ngăn chặn một vụ lừa đảo deepfake đơn giản hơn.

Trong trường hợp nghi ngờ có một cuộc tấn công nhại giọng nói, ông Roberts cho biết, “Đầu tiên quý vị nên nói, ‘em yêu, anh sẽ gọi lại cho em ngay.’”

Ông lưu ý rằng những kẻ lừa đảo sẽ bịa ra một cái cớ tại sao quý vị không thể gọi lại để xác minh danh tính của họ. Có một mẹo để đánh lạc hướng bọn tội phạm dùng âm thanh nhân bản để giả mạo một vụ bắt cóc là hỏi người gọi những câu hỏi về các thông tin riêng tư không được công khai.

Ông Roberts nói thêm, “Hãy thảo luận về nạn lừa đảo này với gia đình quý vị trước khi vụ việc thực sự xảy ra để họ hiểu những gì quý vị đang làm.”

Ông nhấn mạnh tầm quan trọng của việc không sử dụng các địa chỉ thư điện tử cá nhân có tên đầy đủ hoặc các số liên quan đến ngày sinh của người dùng.

Ngoài ra, người dùng không bao giờ nên sử dụng cùng một mật khẩu đăng nhập cho nhiều trương mục. Ông Roberts lưu ý rằng điều đầu tiên mà tin tặc làm khi lấy được mật khẩu là thử đăng nhập vào mọi trang web có thể để xem mật khẩu này trùng khớp với trương mục nào.

Điều này đúng với các trương mục ngân hàng, lưu trữ đám mây, truyền thông xã hội, v.v.

Nhưng trong khi deepfake đã giúp nâng cao tiêu chuẩn của bọn lừa đảo trực tuyến, thì các phương pháp theo dõi họ vẫn không thay đổi.

Ông Ikoev nói: “Quy trình không thay đổi. AI chỉ là nội dung… còn breadcrumb (*) mà bọn tội phạm để lại thì luôn giống nhau.”

(*) breadcrumb: một tập hợp các liên kết cho phép cho người dùng xác định được vị trí hiện tại của mình trên cấu trúc website

Người ta có thể thiết lập tốt việc lần theo dấu vết bọn lừa đảo, nhưng không thể đưa ra một cách thức rõ ràng để thu hồi số tiền bị mất.

Theo một phân tích, các vụ lừa đảo tài chính bằng deepfake có thể dao động từ 243,000 đến 35 triệu USD.

Ví dụ như, một dụ dỗ đầu tư tiền mã hóa bằng cách sử dụng các chân dung giả mạo ông Elon Musk được cho là khiến người tiêu dùng Hoa Kỳ thất thoát khoảng 2 triệu USD trong sáu tháng.

Có lẽ điều rắc rối hơn là bất cứ ai cũng có thể tạo ra một deepfake. Ông Ikoev giải thích rằng tất cả những gì mà người ta cần để tạo một deepfake trên điện thoại thông minh là một card đồ họa và xem một vài hướng dẫn trên web.

Ông nói: “Vậy là đủ để quý vị tiến hành.”

Những gì có thể xảy ra tiếp theo?

Thời điểm diễn ra cuộc bầu cử tổng thống Hoa Kỳ sắp tới vào năm 2024 là rất bấp bênh, do sự gia tăng của các nội dung deepfake.

Ông Roberts cho biết người Mỹ nên chuẩn bị tinh thần cho một cuộc đua bầu cử đầy rẫy những kẻ lừa đảo sử dụng kho vũ khí deedfake.

Bộ An ninh Nội địa Hoa Kỳ cũng bày tỏ lo ngại về việc sử dụng công nghệ này khi nêu rõ: “Mối đe dọa từ deepfake và truyền thông giả không đến từ công nghệ được sử dụng để tạo ra các sản phẩm này, mà từ xu hướng tự nhiên của con người là tin vào những gì họ nhìn thấy.”

Lúc này, những rắc rối mới đã xuất hiện.

Trước đó trong năm nay, các video cho thấy các chính trị gia Hoa Kỳ đưa ra những nhận xét rất khác thường đã nổi lên.

Một video liên quan đến việc bà Hillary Clinton ủng hộ ông Ron DeSantis, một ứng cử viên tổng thống đầy triển vọng thuộc Đảng Cộng Hòa.

Một video khác mô tả Tổng thống Joe Biden đang có những lời nhận xét vô cùng giận dữ về một người chuyển giới.

Theo ông Roberts, đây mới chỉ là bước khởi đầu.

Ông nói: “Deepfake sẽ được sử dụng nhiều để can thiệp vào chính trị,” đồng thời cho biết thêm rằng công nghệ này sẽ khiến công chúng đối mặt với sự kiện tiếp theo có tầm cỡ như COVID nhưng tồi tệ hơn nhiều.

“Tôi không nói về loại thông tin sai lệch như mô tả của cánh tả cấp tiến. Tôi đang nói về những lời dối trá có chủ ý được sử dụng để thao túng xã hội trên toàn thế giới.”

Deep fake là gì?

Deepfake là gì?

Một giải pháp được nhiều nước cân nhắc là đưa ra luật quy định việc tạo và phát tán nội dung Deepfake là bất hợp pháp. Vào tháng 10, 2019, California quy định rằng việc tạo hoặc chia sẻ video, hình ảnh, giọng nói của các chính trị gia bằng công nghệ Deepfake trước cuộc bầu cử là phạm luật. Tuy nhiên, giải pháp này vẫn không hiệu quả, do tính ẩn danh và không biên giới của Internet. Trong giai đoạn này, các hãng công nghệ lớn như Facebook, Google và Twitter phải hành động để hạn chế sự lan truyền của những video giả mạo.

Thông thường, các tin xấu và gây tranh cãi luôn lan truyền rất nhanh, nhưng các tin đính chính sau đó lại ít người biết tới. Tuy nhiên, nếu mọi người có xu hướng hoài nghi mọi video họ xem, kể cả thông tin chính thống, ông Hany Farid, một trong những chuyên gia hàng đầu thế giới về deepfake, nói: "Nếu bạn không còn tin những video hay những đoạn âm thanh mà bạn xem, đó thật sự là nguy cơ an ninh quốc gia nghiêm trọng.” Ông dự đoán trong tương lai gần, công nghệ Deepfake sẽ phát triển từ một hiện tượng lạ trên Internet thành một công cụ tàn phá xã hội, công kích chính trị. Ông cũng cho rằng mọi người cần có sự chuẩn bị để đối mặt với vấn đề này.

Theo thống kê, tính đến tháng 9/2019, có 96% video deepfake chứa nội dung khiêu dâm. Có một số trang web chuyên phát những nội dung này và thu hút rất nhiều lượt xem trong suốt hai năm gần đây. Những nội dung trong đó hầu hết được tổng hợp từ những video với sự ghép mặt của những người nổi tiếng.

Ai cũng có thể là nạn nhân của Deepfake. Nếu một ngày nào đó bỗng nhiên bạn thấy mặt mình xuất hiện trong một bộ phim khiêu dâm và được lan truyền trên mạng, với tốc độ lan truyền nhanh như hiện nay thì việc một video khiêu dâm sẽ nhanh chóng đến tay bạn bè và người thân của bạn. Khi đó danh dự và mọi người sẽ nhìn và đánh giá bạn ra sao? Đây là ví dụ rõ ràng nhất cho thấy sự xuất hiện của công nghệ Deepfake đã khiến công chúng càng khó phân biệt đâu là thật giả. Và những người có ý đồ dẫn dắt dư luận sẽ cố gắng khai thác điều này, làm cho tình hình ngày càng trở nên tồi tệ hơn.Cách tạo một Deepfake.

Vũ khí hạt nhân tiêu diệt thế giới vật chất. Vũ khí Deepfake tiêu diệt giá trị tinh thần.

Sự giả mạo và dối trá

Con người ngày nay sống trong một thế giới đầy sự giả mạo, dối trá, không ai còn tin những giá trị thật của lời nói, con người thật, sản phẩm hàng hóa thật. Các bộ phận trong con người như tóc, tai, mắt, mũi, chân mày, lông mi, đến cả ngực, mông đều có thể làm giả. Các sản phẩm mỹ thuật như cây, hoa, thú vật kiểng cũng được làm giả bằng các loại nhựa.

Tương tác giữa người với người

Mối quan hệ giữa người với người luôn tồn tại hai hiện tượng song hành đó là thật và giả. Thật, giả có lúc rất rõ ràng, dễ nhận biết, nhưng cũng có lúc lẫn lộn, phức tạp, khó nhận biết. Sự thật khách quan được hiểu cái gì đó là đúng hoặc có thể được chứng minh với bằng chứng cụ thể.

Quan hệ xã hội, kế cá các quan hệ thân thuộc như cha mẹ , vợ chồng, con cái , anh em, bà con , thầy trò, chủ tớ... phần lớn đều được giao tiếp qua sự giả dối. Phải nhận rằng, con người hiện nay sống theo quan niệm người khác, suy nghĩ theo người khác, nói theo người khác, hành động theo người khác, rất hiếm cái nào là thực tế khách quan, chân thật.